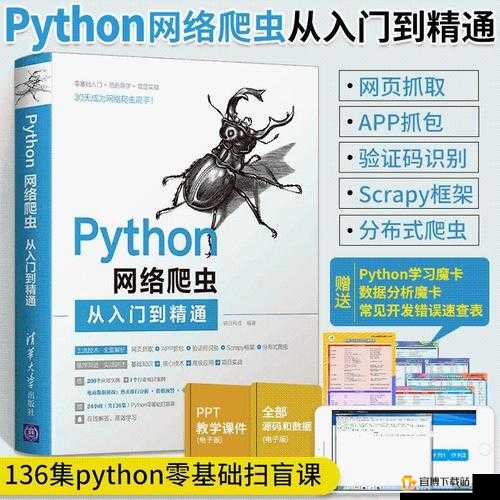

的网站PYTHON爬虫:从入门到精通

简介

随着互联网的迅猛发展,信息获取的方式变得越来越多样化。网站作为一种新兴的娱乐形式,吸引了大量用户的关注。如何从这些网站中高效、快速地获取所需的信息,成为了许多开发者和数据爱好者们面临的挑战。Python作为一门简单易学且功能强大的编程语言,成为了实现这一目标的首选工具。本文将从入门到精通,详细介绍如何使用Python编写爬虫程序,爬取网站的数据,帮助你快速掌握这项技能,并在搜索引擎中脱颖而出。

---

一、Python爬虫的基本概念

Python爬虫,顾名思义,就是利用Python编写的程序,自动从互联网上获取信息的工具。爬虫的核心在于模拟人类的浏览行为,通过请求网页、解析内容、提取数据等步骤,实现数据的自动化获取。

1. 什么是爬虫?

爬虫可以被看作是一个自动化的信息收集者。它们通过发送HTTP请求获取网页内容,然后通过解析HTML结构提取所需的信息。爬虫的应用非常广泛,从搜索引擎的网页索引,到数据分析、市场调研、舆情监控等领域都有其身影。

2. Python为何适合爬虫开发

Python具有简洁的语法和丰富的库支持,如`requests`用于HTTP请求,`BeautifulSoup`和`lxml`用于HTML解析,`Scrapy`框架更是为爬虫量身定制。这些库大大简化了爬虫的开发过程,使得即使是初学者也可以快速上手。

3. 爬虫的合法性与道德

在进行爬虫开发时,了解和遵守网站的`robots.txt`文件是非常必要的。合理控制爬虫的访问频率,避免对网站造成压力,保护个人隐私和数据安全,都是我们必须遵守的道德准则。

4. 基本的爬虫流程

一个基本的爬虫流程包括:发送请求、获取响应、解析内容、提取数据和存储数据。每个步骤都需要仔细设计和实现,以确保爬虫的高效和稳定。

5. 爬虫面临的挑战

爬虫在实际应用中会遇到各种挑战,如反爬虫机制、动态加载内容、JavaScript渲染页面等。这些问题需要我们不断学习和探索解决方案。

---

二、环境搭建与工具选择

在开始编写爬虫之前,首先需要搭建一个适宜的开发环境,并选择合适的工具。

1. Python环境安装

Python的安装非常简单,可以从官方网站下载适合自己操作系统的安装包。建议使用Python 3.x版本,因为其包含了许多新特性和优化。

2. 必要库的安装

使用`pip`工具可以轻松安装所需的Python库。常用的有`requests`、`BeautifulSoup4`、`lxml`、`scrapy`等。可以通过`pip install [库名]`来安装。

3. 开发环境的选择

可以选择如PyCharm、VS Code等支持Python开发的IDE,这些IDE提供了语法高亮、自动补全、调试等功能,极大提高了开发效率。

4. 虚拟环境的使用

为了避免不同项目之间的依赖冲突,建议使用`virtualenv`或`conda`创建虚拟环境,隔离项目依赖。

5. 代理与VPN的使用

为了应对反爬虫机制,可以使用代理服务器或VPN来隐藏真实IP地址,提高爬虫的稳定性和匿名性。

---

三、基础爬虫编写

有了环境和工具,接下来就是编写一个基础的爬虫程序。

1. 发送HTTP请求

使用`requests`库发送GET或POST请求,获取网页内容。

2. HTML解析

解析获取到的HTML内容,可以使用`BeautifulSoup`或`lxml`进行解析,提取所需的标签和数据。

3. 数据提取与存储

提取出有用的信息后,可以选择存储到本地文件(如CSV、JSON)或数据库(如MySQL、MongoDB)中。

4. 处理动态内容

对于使用JavaScript动态加载的内容,可以使用`Selenium`模拟浏览器行为,获取渲染后的页面内容。

5. 错误处理与日志记录

编写爬虫时,错误处理和日志记录是必不可少的部分,确保程序在遇到问题时能够优雅地处理。

---

四、进阶爬虫技巧

当基础爬虫能够正常运行后,可以进一步学习和应用一些高级技巧。

1. 多线程与异步爬虫

使用`threading`或`asyncio`库实现多线程或异步爬虫,提高爬取效率。

2. 反爬虫策略与对策

了解常见的反爬虫技术,如IP封锁、验证码、JavaScript混淆等,并学习如何绕过这些限制。

3. 爬虫的调度与管理

使用`Scrapy`框架可以更方便地管理和调度爬虫任务,实现分布式爬虫。

4. 数据清洗与分析

爬取的数据往往需要清洗和预处理,才能进行后续的分析和应用。

5. 法律与道德考量

在爬虫的使用中,始终要注意遵守法律法规和道德标准,避免侵权和不当使用数据。

---

五、案例分析:网站爬虫实战

通过一个具体的案例,展示如何从网站中爬取数据。

1. 选择目标网站

选择一个网站作为目标,分析其页面结构和数据加载方式。

2. 编写爬虫代码

从发送请求、解析HTML、提取数据到存储数据,逐步实现爬虫功能。

3. 处理动态加载内容

如果网站使用JavaScript动态加载内容,如何使用`Selenium`进行处理。

4. 优化与改进

根据实际情况,优化爬虫的效率,处理可能出现的错误和异常。

5. 数据分析与应用

将爬取的数据进行分析,提取有价值的信息,为后续的应用提供数据支持。

---

通过以上内容,我们从基础概念到实战案例,详细探讨了如何使用Python进行网站的爬虫开发。希望本文能为你提供有价值的指导,帮助你在这一领域快速成长,并在搜索引擎中取得优异的排名。记住,爬虫的开发不仅是技术的展示,更是责任的体现,合理合法地使用爬虫技术,才能真正发挥其价值。